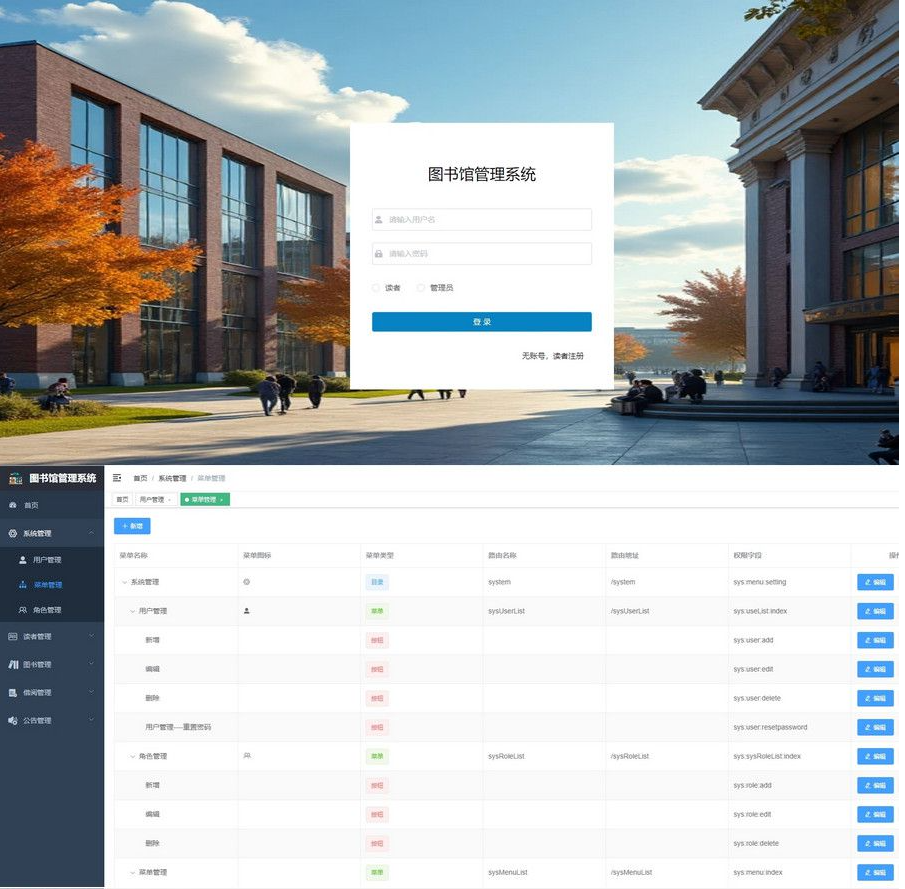

一、安装ollama

1.进入>ollama官网下载

![图片[1]-本地部署Deepseek的俩种姿势(一)](https://cdn.jsdelivr.net/gh/Mj6666666/blogimg@main/20250205134506605.png)

![图片[2]-本地部署Deepseek的俩种姿势(一)](https://cdn.jsdelivr.net/gh/Mj6666666/blogimg@main/20250205133933594.png)

2.根据自己电脑系统下载对应的安装包,我安装的是windows版本的,不同版本流程是一样的。

ollama安装包windows版本

提取码:msiq

![图片[3]-本地部署Deepseek的俩种姿势(一)](https://cdn.jsdelivr.net/gh/Mj6666666/blogimg@main/20250205134511673.png)

![图片[4]-本地部署Deepseek的俩种姿势(一)](https://cdn.jsdelivr.net/gh/Mj6666666/blogimg@main/20250205134836327.png)

双击安装,安装之后会有一个羊驼的图标,

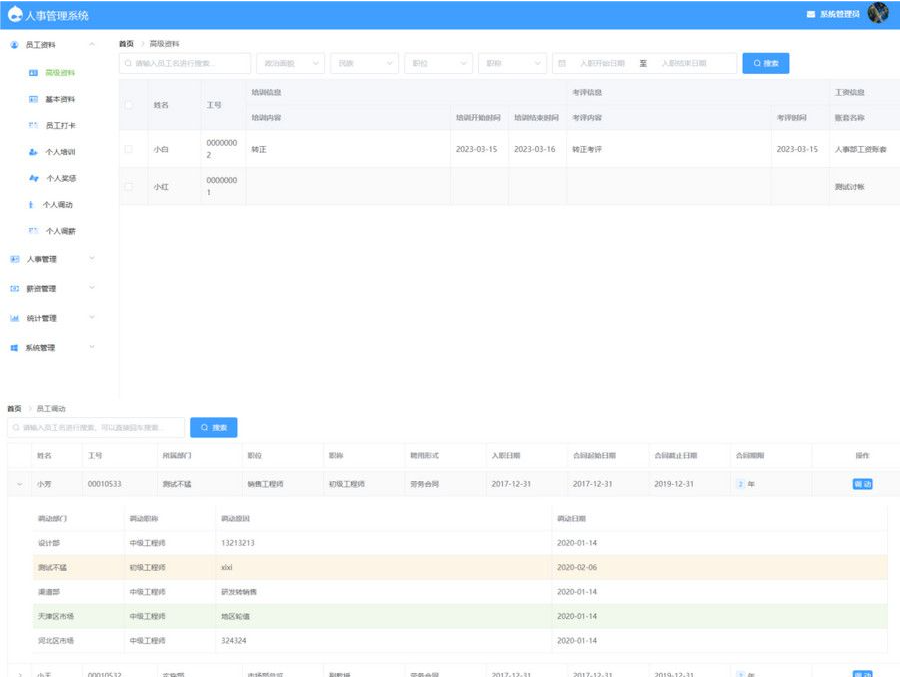

二、选择对应版本的deepseek

点击官网的>models,选择>deepseek-r1。

![图片[5]-本地部署Deepseek的俩种姿势(一)](https://cdn.jsdelivr.net/gh/Mj6666666/blogimg@main/20250205135638768.png)

选择版本根据自己的电脑配置来选。具体参考下面的表格。

![图片[6]-本地部署Deepseek的俩种姿势(一)](https://cdn.jsdelivr.net/gh/Mj6666666/blogimg@main/20250205135834016.png)

| 模型参数 | windows配置 | Mac配置 | 适用场景 |

| 1.5B | 内存:4GB 显卡:集显(如GTX1050) 存储:5G | 内存:8GB(统一内存) 芯片:M1/M2/M3 存储:5G | 简单文本/基本代码补全 |

| 7B | 内存:8-10GB 显卡:GTX1660(4-bit量化) 存储:8G | 内存:18GB 芯片:M2pro/M3 存储:8G | 中等复杂问答/代码调试 |

| 8B | 内存:12GB 显卡:RTX3060(8GB VRAM) 存储:10G | 内存:24GB 芯片:M2 MAX 存储:10G | 多轮对话/文档分析 |

| 14B | 内存:24GB 显卡:RTX3090(24GB VRAM) 存储:20G | 内存:32GB 芯片:M3 MAX 存储:20G | 复杂推理/技术文档生成 |

| 32B | 内存:48GB 显卡:RTX4090(4-bit量化) 存储:40G | 内存:64GB 芯片:M3 Ultra 存储:40G | 科研计算/大规模数据处理 |

| 70B | 内存:64GB 显卡:双RTX4090(NVLink) 存储:80G | 内存:128GB(外接显卡坞) 存储:80GB | 企业级AI服务/多模态处理 |

| 671B | 内存:256GB+ 显卡:8xH100(通过NVLink连接) 存储:1TB+ | 暂不支持 | 超大规模云端推理 |

复制对应版本的安装指令。按win+r,输入cmd,打开终端窗口,粘贴对应的指令,回车。我这里安装8B的就够用了。指令执行时会给安装对应的模型,请耐心等待,不要关闭终端。

![图片[7]-本地部署Deepseek的俩种姿势(一)](https://cdn.jsdelivr.net/gh/Mj6666666/blogimg@main/20250205142843364.png)

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

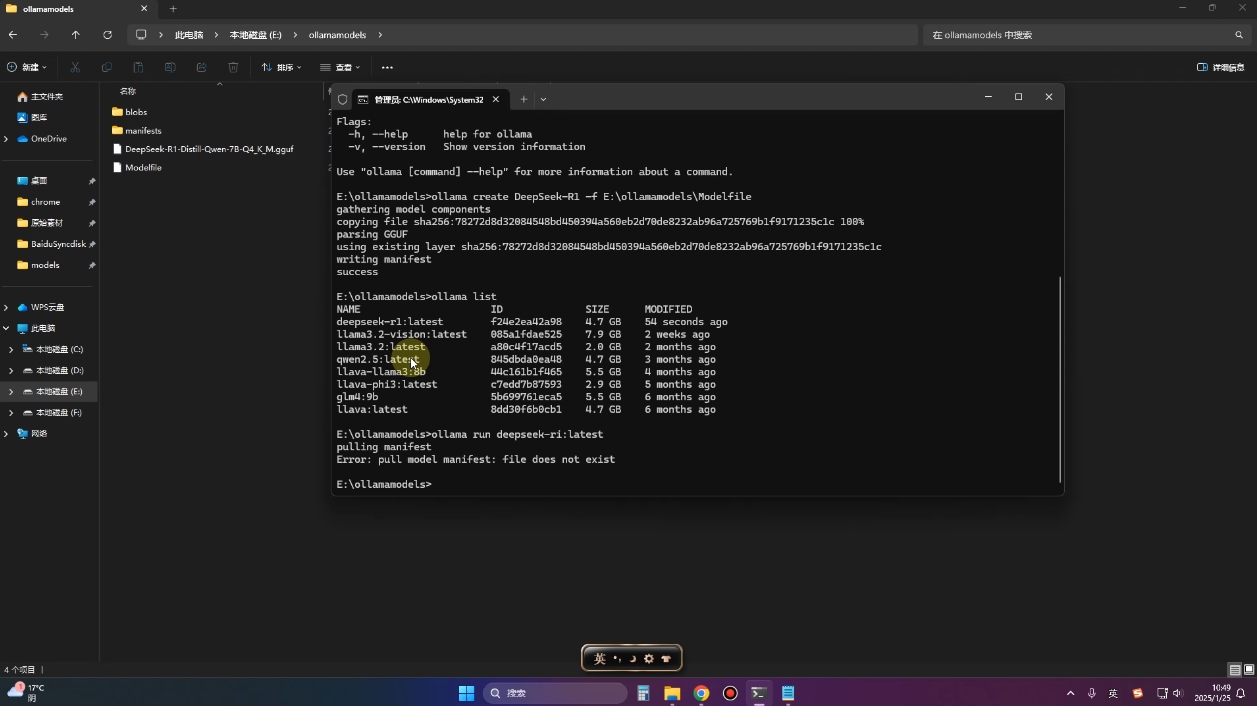

ollama run deepseek-r1:70b三、安装之后在终端输入对应指令即可

![图片[8]-本地部署Deepseek的俩种姿势(一)](https://cdn.jsdelivr.net/gh/Mj6666666/blogimg@main/20250205143245538.png)

以后使用时打开终端,输入当时安装对应版本的指令就可以再次唤起,第二次输入指令时不会安装,可直接提问。

© 版权声明

THE END